Masterarbeit: Der Digitale Zwilling des Menschen: Implementierung und Analyse eines 3D-Avatars für die 3D-Simulation.

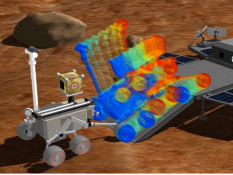

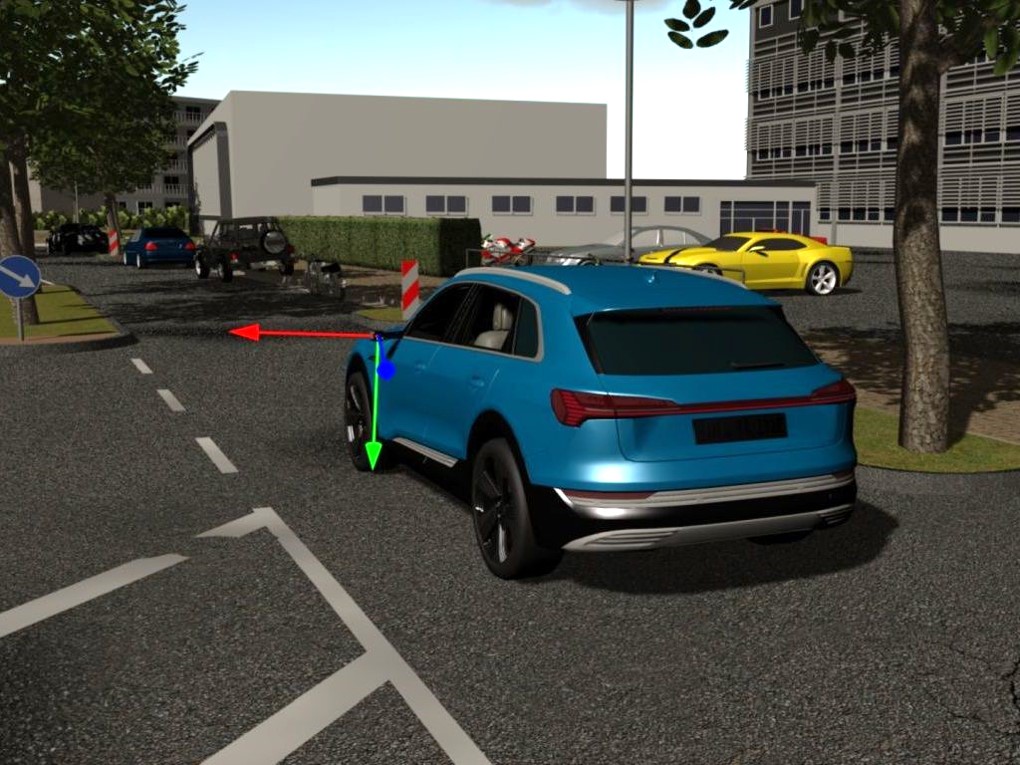

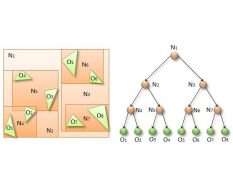

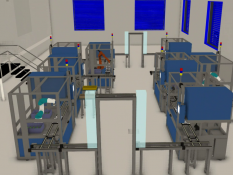

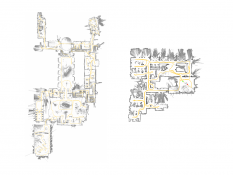

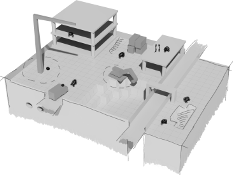

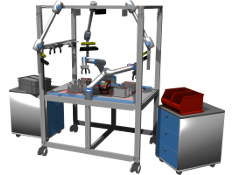

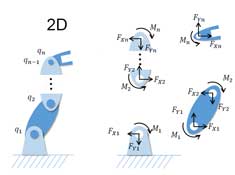

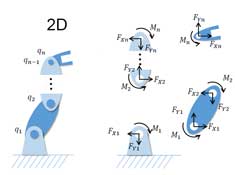

Im Bereich der Mensch-Roboter-Kollaboration wird dem Menschen in der Produktion ein immer höherer Stellenwert zugeordnet. Simulatoren solch komplexer Produktionsstraßen beschränken sich jedoch bisher auf die reinen „starren“ Komponenten aus Maschinen und Produkten. Den Menschen als Teil dieses Systems (in der Simulation) zu implementieren ist Ausgangspunkt dieser Arbeit.

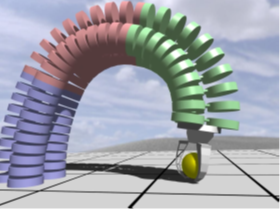

Mit Hilfe des Open Source Tools für 3D Charaktere MAKEHUMAN [1] können realitätsnahe 3D-Avatare geschaffen werden. Diese sollen im Rahmen dieser Arbeit in ein 3D-Simulationssystem integriert werden, welches auf eine starrkörperbasierte Robotersimulation spezialisiert ist.

Zentrale Aspekte der Arbeit sind:

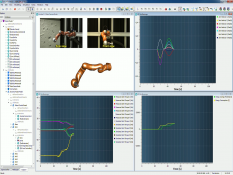

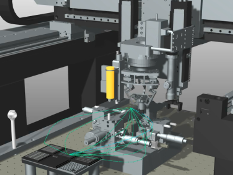

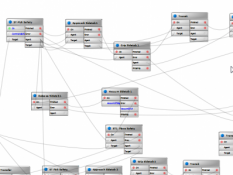

(1) die Integration des 3D-Modells des menschlichen Avatars (aus MAKEHUMAN) in die 3D-Simulation VEROSIM

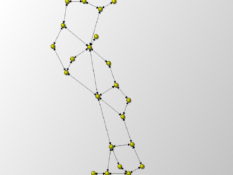

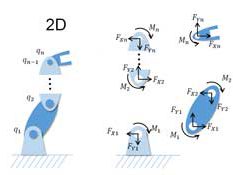

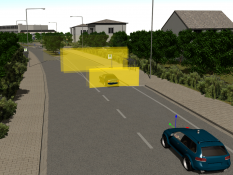

(2) die Integration bzw. Abbildung der Skelettdarstellung des Avatars (zur direkten Steuerung der Extremitäten mittels Motion Capture Anzügen oder einer Kinect v2 Kamera)

(3) Implementierung einer GUI zur direkten Kontrolle des Avatars

(4) Implementierung eines Interaktions-Frameworks

– zwischen Avatar und starren Körpern in der 3D-Simulation, sowie

– zwischen mehreren Avataren

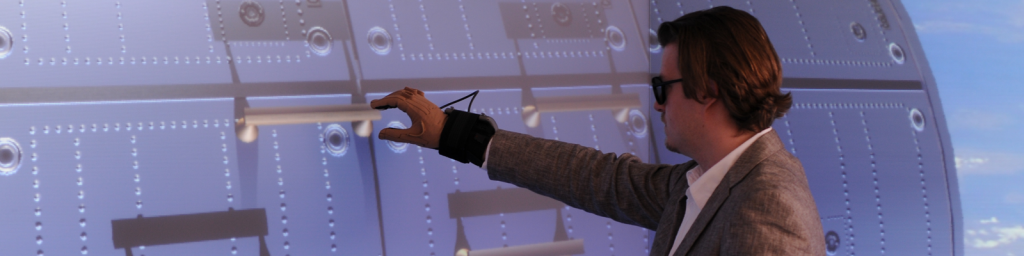

(5) Steuerung des Avatars mit der Microsoft Kinect v2 zur Analyse und Evaluation der Performance

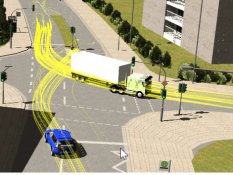

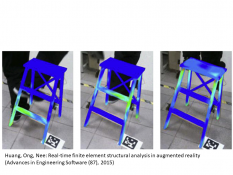

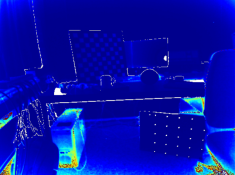

(6) Teilautomatisierte Analyse (und Visualisierung) ergonomischer Key Performance Indicator des Menschen auf Basis des RULA Scores [2]

Stichworte: Starrkörpersimulation, C++, Qt, Echtzeitfähigkeit, Virtual Human, Ergonomie

Betreuer: Atorf

[1] http://www.makehumancommunity.org/

[2] http://ergo-plus.com/wp-content/uploads/RULA-A-Step-by-Step-Guide1.pdf

Weitere Arbeiten

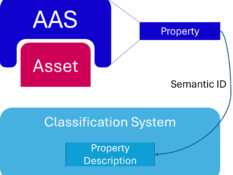

Klassifikationssystem für Merkmale Digitaler Zwillinge auf Basis der Industrie 4.0-Verwaltungsschale

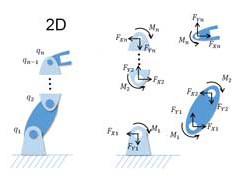

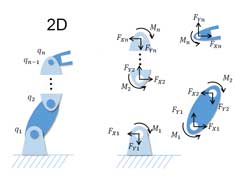

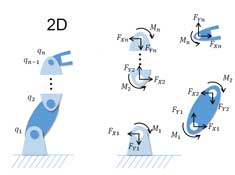

Implementation of an Accelerated Projected Gradient Descent Solver for Multibody Dynamics Simulation

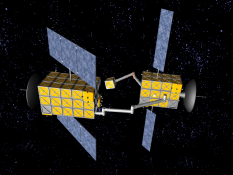

MA: Automatisierung der Verhandlung von digitalen Nutzungsrechten durch Self-sovereign Digital Twins