Bachelorarbeit/Masterarbeit: Intuitive Mensch-Maschine-Interaktion mittels Gestenerkennung in der 3D Simulation.

Die Gestenerkennung behandelt die mathematische Interpretation menschlicher Bewegungen durch einen Computer. Neben der Gesichtserkennung, Spracherkennung, Augen-/oder Lippenbewegungs- Tracking ist die Gestenerkennung zentraler Bestandteil der „perceptual user interfaces“ (PUI), welche eine effiziente und einfache Nutzerschnittstelle bereitstellen.

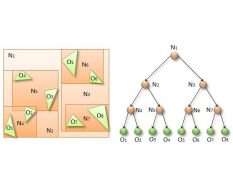

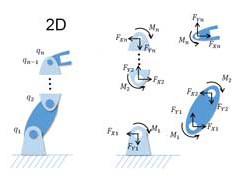

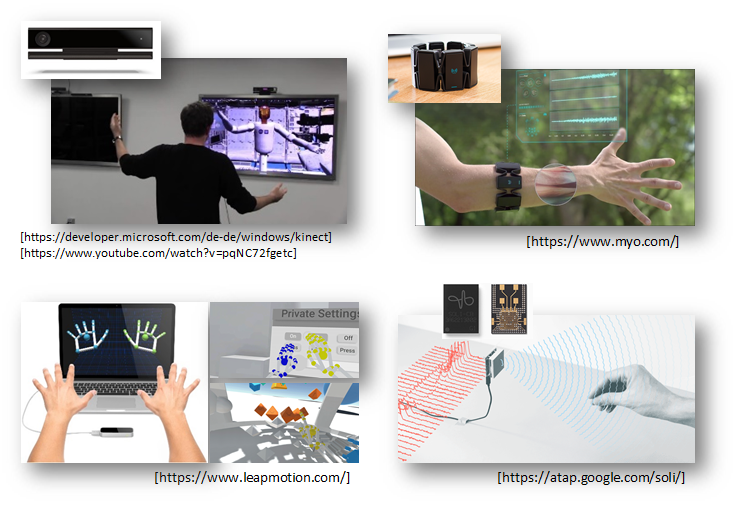

Zur Kategorisierung des großen Feldes der Gestenerkennung kann man diese im Sinne der verwendeten Hard- und Software folgendermaßen einteilen (siehe auch Abb.):

- Controller-basiert

(wie z.B. Nintendo Wii, Thalmic Labs Myo, Google Daydream Controller) - Optisch

- Kamerabasierte Gestenerkennung (wie z.B. Microsoft Kinect)

- Infrarot Eingabegeräte (wie z.B. LeapMotion)

- Phasenbasiert (Radar) (wie z.B. Google Soli)

Im Bereich der Controller-basierten Eingabegeräte beschränkt sich die Gestenerkennung auf Position, Orientierung, Geschwindigkeit, oder Beschleunigungsprofile. Im Bereich von optisch erfassten Gesten beinhaltet dieses vielmehr den Bereich der Bildverarbeitung. Hierbei bringen oft die entsprechenden SDKs vordefinierte (und optimierte) Bibliotheken mit. Open Source Projekte dagegen, wie OpenCV oder z.B. das Gesture Recognition Toolkit (https://github.com/nickgillian/grt), geben einen ganzheitlicheren Ansatz im Bereich der Gestenerkennung.

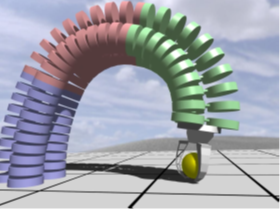

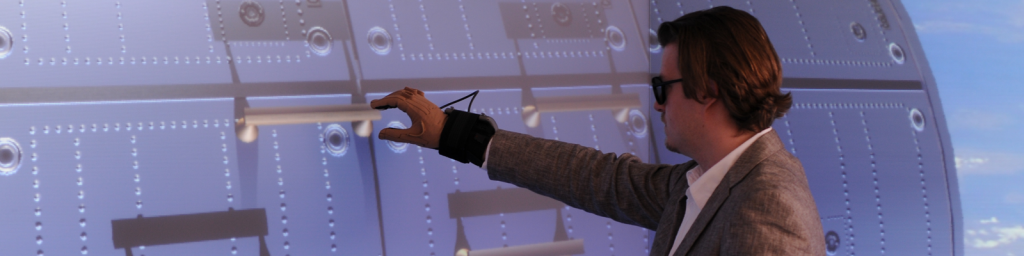

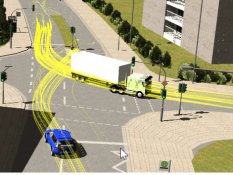

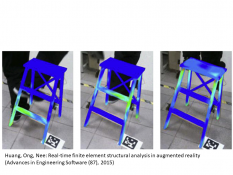

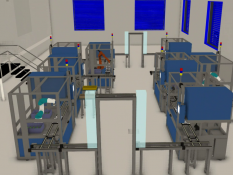

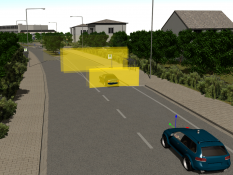

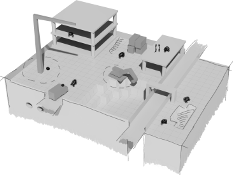

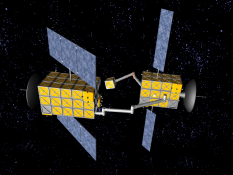

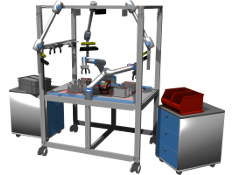

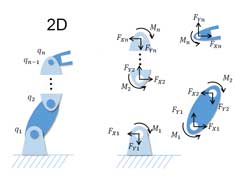

Im Bereich von VR (und AR) sind die Anwendungsmöglichkeiten der Gestenerkennung nahezu endlos. Neben der kostengünstigen Anschaffung steht vor allem die einfache, direkte, intuitive Nutzung im Vordergrund. Zusätzlich zu den aktuellen Trends im Bereich VR (siehe Oculus Rift oder HTC Vive) können die Möglichkeiten der Gestenerkennung hier außerordentlich gut genutzt werden, um einfach virtuelle Einsatzszenarien abzubilden, welche sonst erheblich umfangreichere Aufbauten benötigen würden. Ein Beispiel hierfür sind teleoperativ gesteuerte Roboter, welche komplexe und oft stark angepasste oder extra entwickelte Eingabegeräte benötigen, können diese vorerst auch durch das Abbilden des menschlichen Skelettes in der Kinect in einem virtuellen Testszenario genutzt werden. Des Weiteren können entwickelte Gestenerkennungsalgorithmen auch zusätzlich im finalen Szenario Einsatz finden, oder in anderen Anwendungen genutzt werden.

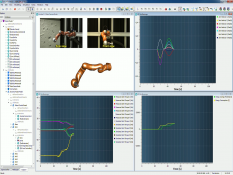

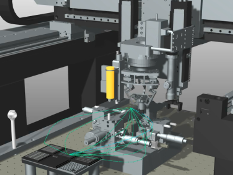

Im Rahmen dieser Bachelor/Masterarbeit soll auf der einen Seite Hardware (z.B. Kinect 2, Myo, LeapMotion) untersucht und an ein bestehendes 3D Simulationssystem angebunden werden, als auch auf der anderen Seite Algorithmen zur allgemeinen Gestenerkennung implementiert werden, um schlussendlich ein ganzheitliches System aus Mensch und 3D Simulation (und eventuell auch realer Hardware) zu schaffen.

Durch die gute Skalierbarkeit dieser Arbeit ist diese als Bachelor- oder Masterarbeit durchführbar.

Voraussetzungen hierfür sind neben Kenntnissen in C++ (und Qt), erste Erfahrungen in der Anbindung von C++ basierten SDKs, insbesondere das Interesse und die Lust an Hardware-naher Softwaregestaltung nötig.

Stichworte: 3D Simulation, Gestenerkennung, Kinect, Myo, LeapMotion

Betreuer: Cichon

Weitere Arbeiten

MA: Automatisierung der Verhandlung von digitalen Nutzungsrechten durch Self-sovereign Digital Twins