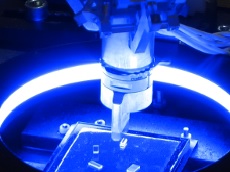

In dem Projekt „IntellAct“ wird ein System entwickelt, das von Menschen demonstrierte Montageaufgaben durch Beobachtung erlernen und mit Robotern wiedergeben kann. Ein derartiges intelligentes System kann dann genutzt werden, um beispielsweise industrielle Roboter ohne konventionelle Roboterprogrammierung schneller zum Einsatz zu bringen oder um kritische Montageaufgaben zum Beispiel an Bord der Internationalen Raumstation mit Robotern überwachen und unterstützen zu können.

Fachlich besteht eine große Herausforderung dabei darin, die detaillierte Signalebene der Handhabung (Trajektorien, Kräfte und Momente) mit der abstrakten Symbolebene zu verbinden, auf der ein Erlernen und „Verstehen“ der Montagesituation erzielt wird. Vom Projektteam wurde dazu ein Konzept entwickelt, um eine beobachtete menschliche Handhabung über mehrere Stufen zu interpretieren und zu abstrahieren, ohne wesentliche Details zu verlieren, die zur Ausführung durch Roboter notwendig sind.

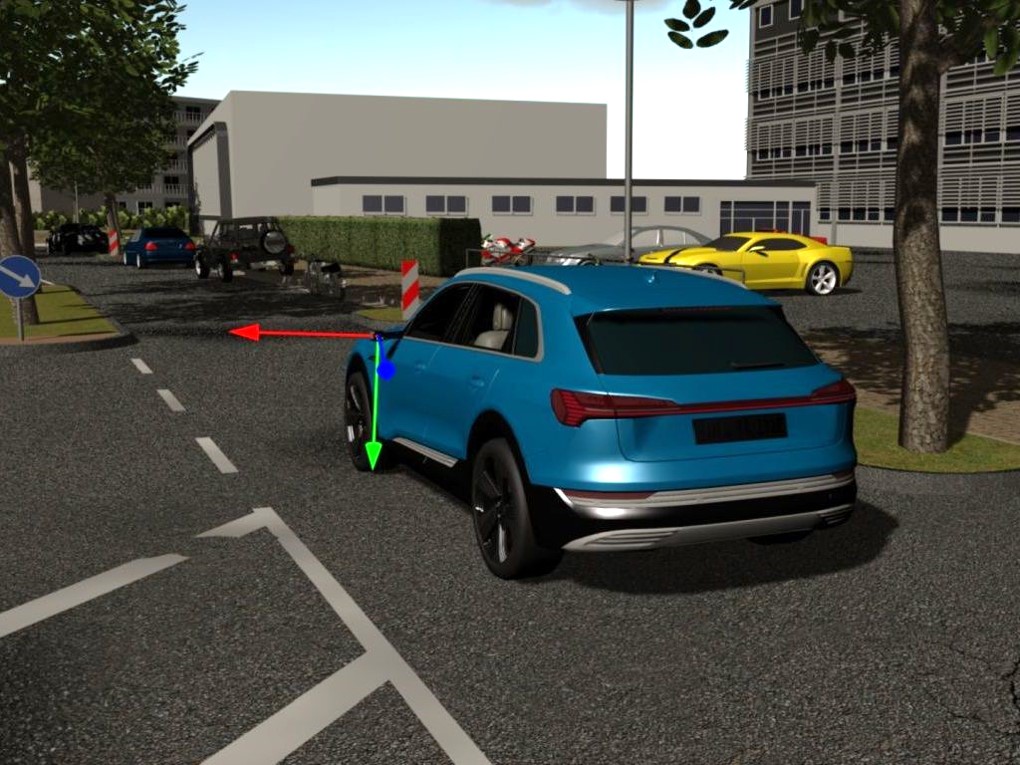

Der Beitrag des MMI in „IntellAct“ besteht darin, ein Virtuelles Testbed bereitzustellen, in dem Systemkomponenten unter kontrollierten, idealen Bedingungen entwickelt und trainiert werden können. So werden beispielsweise die Sensor- und Lernalgorithmen in der Virtuellen Realität trainiert, indem der Trainer Montageaufgaben mit Datenhandschuhen durchführt und dabei Fehlerfaktoren wie Sensorrauschen und Fehlgriffe einstellen und prüfen kann. Auf diese Weise tragen die Arbeiten des MMI in „IntellAct“ insbesondere dazu bei, dass bereits frühzeitig im Projekt die Entwicklung von „high-level“ Komponenten begonnen wurde, die üblicherweise erst nach Auswahl, Installation und Inbetriebnahme der Sensorhardware starten kann.

Siehe http://intellact.sdu.dk/.